Tecnologia

DeepSeek, cos'è e come funziona l'intelligenza artificiale cinese che fa tremare gli Usa

La startup di Hangzhou sfida i giganti con risorse limitate e una visione open source che privilegia l’efficienza e l’apertura. E sta mettendo paura a Wall Street, dove le Big Tech stanno perdendo terreno

di Stefano Silvestri 27 Gennaio 2025 16:10

Nonostante il clamore suscitato in queste ore dal modello DeepSeek R1, la startup cinese che lo ha sviluppato rimane poco conosciuta al grande pubblico. Con sede a Hangzhou, DeepSeek è stata fondata nel luglio 2023 da Liang Wenfeng, un ex studente dell’Università di Zhejiang con una formazione in ingegneria dell’informazione ed elettronica.

L’azienda è stata incubata da High-Flyer, un hedge fund creato dallo stesso Liang nel 2015. L’obiettivo dichiarato è ambizioso: sviluppare un’intelligenza artificiale generale (AGI), capace di competere e superare gli esseri umani in una vasta gamma di compiti. Una visione, questa, che a molti ricorderà quella di Sam Altman.

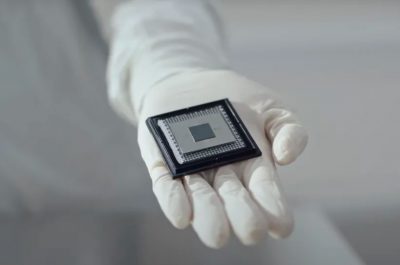

L’addestramento di modelli linguistici di grandi dimensioni (LLM) richiede una combinazione di competenze avanzate e risorse computazionali significative. Come sappiamo, le restrizioni imposte dagli Stati Uniti all’esportazione di semiconduttori avanzati hanno complicato non poso la vita alle aziende cinesi di intelligenza artificiale. Liang ha però affrontato questa sfida preparandosi con largo anticipo: prima dell’introduzione delle sanzioni, High-Flyer ha accumulato una considerevole riserva di chip Nvidia A100, attualmente vietati per l’esportazione in Cina.

Secondo il media cinese 36Kr, DeepSeek possiede almeno 10.000 unità. Altre stime, come quella di Dylan Patel, fondatore di SemiAnalysis, parlano addirittura di almeno 50.000 unità. Questa lungimiranza ha permesso a DeepSeek di costruire modelli di competitivi combinando le GPU più avanzate con quelle a bassa potenza.

La competizione nello spazio dell’intelligenza artificiale cinese è dominata da giganti come Alibaba e ByteDance, oltre a un ristretto numero di startup sostenute da investitori con ingenti risorse finanziarie. In tale contesto, un’azienda come DeepSeek rappresenta un caso raro. Zihan Wang, un ex dipendente di DeepSeek, ha raccontato al MIT Technology Review che l’azienda offre condizioni di lavoro uniche, garantendo abbondanti risorse informatiche e una libertà di sperimentazione che poche aziende concedono ai neolaureati.

Oltre ai vincoli legati alle sanzioni, DeepSeek affronta anche difficoltà legate all’efficienza delle tecniche di ingegneria cinesi. “Noi [la maggior parte delle aziende cinesi] dobbiamo consumare il doppio della potenza di calcolo per ottenere gli stessi risultati. In combinazione con le lacune nell’efficienza dei dati, ciò può significare la necessità di una potenza di calcolo fino a quattro volte superiore. Il nostro obiettivo è colmare continuamente queste lacune”, ha affermato Liang in un’intervista al media 36Kr nel luglio 2024. DeepSeek ha così trovato modi alternativi per innovare, riducendo l’utilizzo della memoria e accelerando i tempi di calcolo senza sacrificare la precisione. “Il team ama trasformare una sfida hardware in un’opportunità di innovazione”, ha ricordato Wang.

DeepSeek si distingue anche per la scelta di rendere open source i propri modelli, promuovendo la collaborazione nella comunità scientifica e offrendo soluzioni accessibili a sviluppatori e ricercatori con risorse limitate. Questa filosofia contrasta con l’approccio più chiuso di molte aziende della Silicon Valley, e ha subito incontrato il favore di Yann LeCun, Chief AI Scientist di Meta, che vede in DeepSeek la conferma del crescente successo dei modelli di IA open source (come appunto quello di Zuckerberg) rispetto a quelli proprietari. Yann LeCun ha poi ricordato che DeepSeek trae vantaggio da strumenti open source come PyTorch e Llama per sviluppare le proprie innovazioni. Questa apertura consente a chiunque di beneficiare dei risultati raggiunti, accelerando i progressi globali nel settore dell’IA.

Il modello DeepSeek-R1 è stato progettato per compiti complessi come il ragionamento matematico e la programmazione. Grazie a un approccio definito “a catena di pensiero”, il sistema elabora le query in modo graduale, migliorando l’efficienza nella risoluzione dei problemi. Questo metodo, simile a quello utilizzato da ChatGPT o1 di OpenAI, è stato accolto con entusiasmo dalla comunità scientifica per la sua capacità di semplificare problemi complessi. Uno degli elementi distintivi di DeepSeek è l’adozione di un’architettura Mixture of Experts (MoE), che permette di attivare solo una parte dei parametri durante l’inferenza. Questo approccio riduce significativamente i costi computazionali, mantenendo prestazioni elevate. Il risultato è che nel modello DeepSeek-V2, ad esempio, per ogni token vengono attivati solo 21 miliardi di parametri, il che a detta degli esperti garantisce un’elevata efficienza senza compromettere i risultati.

Partiamo da una premessa: non è facile accedere a DeepSeek. Al momento in cui scriviamo il login con Google non funziona (né, da desktop, né da mobile), mentre provando a registrarsi con l’email si ottiene il seguente messaggio di errore: “Your email domain is currently not supported for registration”. Siamo invece riusciti ad accedere a DeepSeek da mobile, autenticandoci con Apple, e ci siamo trovati di fronte a un’app simile a quella di OpenAI. Con uno swipe a sinistra si accede alla cronologia delle nostre sessioni, mentre le impostazioni ci permettono solamente di scegliere lo schema colori. Mancano dunque le numerose opzioni di ChatGPT e il modello non pare avere memoria delle nostre preferenze.

In compenso offre la possibilità di effettuare ricerche analoghe a quelle di SearchGPT e offre la funzione ‘Pensiero Profondo R1’, una caratteristica avanzata per generare risposte più approfondite e strutturate. Quando attivata, la funziona analizza la domanda e il contesto in modo più approfondito, utilizzando una logica più complessa. I tempi di risposta sono altalenanti (alle volte sono istantanei, altre molto lunghi, altre ancora vanno in time-out), dando la sensazione è che in queste ore DeepSeek stia gestendo più traffico di quanto sia in grado di reggerne. Manca inoltre la possibilità di interagire vocalmente col chatbot, che non può neppure generare immagini.

ChatGPT resta al momento su un altro livello ma in un settore dominato dai giganti della tecnologia, DeepSeek si distingue comunque per la capacità di competere con risorse limitate, puntando sull’efficienza e sull’apertura. La sua rapida ascesa è allora la testimonianza di come l’innovazione possa prosperare anche in condizioni apparentemente sfavorevoli. Se però DeepSeek, ridefinirà o meno gli equilibri globali nell’intelligenza artificiale, ora pare presto per dirlo.

L’azienda è stata incubata da High-Flyer, un hedge fund creato dallo stesso Liang nel 2015. L’obiettivo dichiarato è ambizioso: sviluppare un’intelligenza artificiale generale (AGI), capace di competere e superare gli esseri umani in una vasta gamma di compiti. Una visione, questa, che a molti ricorderà quella di Sam Altman.

PRIMA DELLE RESTRIZIONI

L’addestramento di modelli linguistici di grandi dimensioni (LLM) richiede una combinazione di competenze avanzate e risorse computazionali significative. Come sappiamo, le restrizioni imposte dagli Stati Uniti all’esportazione di semiconduttori avanzati hanno complicato non poso la vita alle aziende cinesi di intelligenza artificiale. Liang ha però affrontato questa sfida preparandosi con largo anticipo: prima dell’introduzione delle sanzioni, High-Flyer ha accumulato una considerevole riserva di chip Nvidia A100, attualmente vietati per l’esportazione in Cina.

Secondo il media cinese 36Kr, DeepSeek possiede almeno 10.000 unità. Altre stime, come quella di Dylan Patel, fondatore di SemiAnalysis, parlano addirittura di almeno 50.000 unità. Questa lungimiranza ha permesso a DeepSeek di costruire modelli di competitivi combinando le GPU più avanzate con quelle a bassa potenza.

UN’AZIENDA DIVERSA

La competizione nello spazio dell’intelligenza artificiale cinese è dominata da giganti come Alibaba e ByteDance, oltre a un ristretto numero di startup sostenute da investitori con ingenti risorse finanziarie. In tale contesto, un’azienda come DeepSeek rappresenta un caso raro. Zihan Wang, un ex dipendente di DeepSeek, ha raccontato al MIT Technology Review che l’azienda offre condizioni di lavoro uniche, garantendo abbondanti risorse informatiche e una libertà di sperimentazione che poche aziende concedono ai neolaureati.

Oltre ai vincoli legati alle sanzioni, DeepSeek affronta anche difficoltà legate all’efficienza delle tecniche di ingegneria cinesi. “Noi [la maggior parte delle aziende cinesi] dobbiamo consumare il doppio della potenza di calcolo per ottenere gli stessi risultati. In combinazione con le lacune nell’efficienza dei dati, ciò può significare la necessità di una potenza di calcolo fino a quattro volte superiore. Il nostro obiettivo è colmare continuamente queste lacune”, ha affermato Liang in un’intervista al media 36Kr nel luglio 2024. DeepSeek ha così trovato modi alternativi per innovare, riducendo l’utilizzo della memoria e accelerando i tempi di calcolo senza sacrificare la precisione. “Il team ama trasformare una sfida hardware in un’opportunità di innovazione”, ha ricordato Wang.

UN’IA PER TUTTI

DeepSeek si distingue anche per la scelta di rendere open source i propri modelli, promuovendo la collaborazione nella comunità scientifica e offrendo soluzioni accessibili a sviluppatori e ricercatori con risorse limitate. Questa filosofia contrasta con l’approccio più chiuso di molte aziende della Silicon Valley, e ha subito incontrato il favore di Yann LeCun, Chief AI Scientist di Meta, che vede in DeepSeek la conferma del crescente successo dei modelli di IA open source (come appunto quello di Zuckerberg) rispetto a quelli proprietari. Yann LeCun ha poi ricordato che DeepSeek trae vantaggio da strumenti open source come PyTorch e Llama per sviluppare le proprie innovazioni. Questa apertura consente a chiunque di beneficiare dei risultati raggiunti, accelerando i progressi globali nel settore dell’IA.

LA CATENA DI PENSIERO

Il modello DeepSeek-R1 è stato progettato per compiti complessi come il ragionamento matematico e la programmazione. Grazie a un approccio definito “a catena di pensiero”, il sistema elabora le query in modo graduale, migliorando l’efficienza nella risoluzione dei problemi. Questo metodo, simile a quello utilizzato da ChatGPT o1 di OpenAI, è stato accolto con entusiasmo dalla comunità scientifica per la sua capacità di semplificare problemi complessi. Uno degli elementi distintivi di DeepSeek è l’adozione di un’architettura Mixture of Experts (MoE), che permette di attivare solo una parte dei parametri durante l’inferenza. Questo approccio riduce significativamente i costi computazionali, mantenendo prestazioni elevate. Il risultato è che nel modello DeepSeek-V2, ad esempio, per ogni token vengono attivati solo 21 miliardi di parametri, il che a detta degli esperti garantisce un’elevata efficienza senza compromettere i risultati.

COME SI USA

Partiamo da una premessa: non è facile accedere a DeepSeek. Al momento in cui scriviamo il login con Google non funziona (né, da desktop, né da mobile), mentre provando a registrarsi con l’email si ottiene il seguente messaggio di errore: “Your email domain is currently not supported for registration”. Siamo invece riusciti ad accedere a DeepSeek da mobile, autenticandoci con Apple, e ci siamo trovati di fronte a un’app simile a quella di OpenAI. Con uno swipe a sinistra si accede alla cronologia delle nostre sessioni, mentre le impostazioni ci permettono solamente di scegliere lo schema colori. Mancano dunque le numerose opzioni di ChatGPT e il modello non pare avere memoria delle nostre preferenze.

In compenso offre la possibilità di effettuare ricerche analoghe a quelle di SearchGPT e offre la funzione ‘Pensiero Profondo R1’, una caratteristica avanzata per generare risposte più approfondite e strutturate. Quando attivata, la funziona analizza la domanda e il contesto in modo più approfondito, utilizzando una logica più complessa. I tempi di risposta sono altalenanti (alle volte sono istantanei, altre molto lunghi, altre ancora vanno in time-out), dando la sensazione è che in queste ore DeepSeek stia gestendo più traffico di quanto sia in grado di reggerne. Manca inoltre la possibilità di interagire vocalmente col chatbot, che non può neppure generare immagini.

ChatGPT resta al momento su un altro livello ma in un settore dominato dai giganti della tecnologia, DeepSeek si distingue comunque per la capacità di competere con risorse limitate, puntando sull’efficienza e sull’apertura. La sua rapida ascesa è allora la testimonianza di come l’innovazione possa prosperare anche in condizioni apparentemente sfavorevoli. Se però DeepSeek, ridefinirà o meno gli equilibri globali nell’intelligenza artificiale, ora pare presto per dirlo.

Trending

RICEVI GRATIS LE NOTIZIE IN ANTEPRIMA

RICEVI GRATIS LE NOTIZIE IN ANTEPRIMA